AI技术与网络安全行业的融合,催生了很多技术、产品、场景不同层次的创新。针对这一交叉领域,笔者跟踪了近两年初创公司及大厂产品发布、融资情况以及各类赛事的公开材料,用以研究AI与安全结合的创新机会。

01 框架

分类逻辑如下:首先分为AI for Security和Security for AI两个方向。

AI for Security:使用AI技术赋能已有的安全产品。

例如:微软推出Security Copilot,集成在已有安全产品中以简化人工运营。

Security for AI:将AI应用视为一个新的场景,这一场景的变化将重新组合新老技术,形成新的解决方案。

例如:Reality Defender检测图片及音视频是否由AI生成,以应对AIGC用于金融欺诈、舆情操纵方面的风险。

02 AI安全赛道

本文仅讨论「Security for AI」部分,这一部分的过去两年的相关企业也有大几十家,可以说是泛安全行业最火的赛道,因此需要继续细分:

AI系统的安全问题:AI应用本身也是软件、信息系统,也需要进行信息安全(CIA)的防护。

AI的可信问题:AI应用本身的行为是否可信,以合规场景为主的商业化场景。

AI的滥用问题:黑灰产利用AI技术实施欺诈的防范问题。

03 AI系统安全问题

AI系统首先是一个软件、一个信息系统,因此信息安全的CIA(机密性,完整性,可用性)仍然需要保护。

从攻防的视角而言,「AI系统」作为一个新的对抗场景,其攻击方式出现了很多变化,这和前些年「云安全」作为市场化热点,厂商纷纷发布“攻(防)技战法矩阵”如出一辙。

MITRE、OWASP针对AI模型/AI系统攻击手段的总结

从技术角度,上述Matrix里绝大部分问题可以复用已有安全能力来解决。因此,在这方面初创公司里能够看到“面向AI场景”的WAF、EDR、IDS甚至SecOps、供应链安全等等产品——老技术,新场景——目前已有颇多安全初创/大厂介入。

差异之处在于AI模型层的攻击手段。这部分技术发展包含了大量的学术界的贡献,从14年Adversarial Examples的提出,到17年的One Pixel Attack,到ADVbox提出系统化的模型层红蓝对抗,将攻击定义为投毒(Poisoning)、逃逸(Evasion)、模型提取(Extraction)和推断(Inference)四大类,到后来GPT的Jailbreak以及“奶奶攻击”,相关技术一直在对抗发展。

初创厂商清单

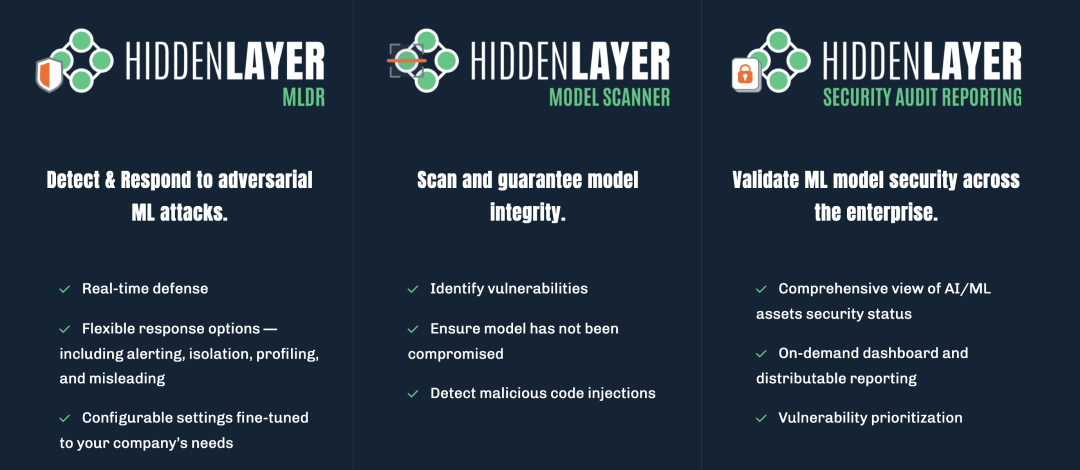

代表厂商:HiddenLayer

HiddenLayer——AI安全赛道的明星厂商,22年3月创立于美国德州,23年获RSAC创新沙盒冠军,随后9月的A轮5000万融资是目前AI安全赛道最高A轮融资额。

早期Hiddenlayer推出的三款核心业务包括:MLDR(Machine Learning Detection & Response)、模型扫描器、配套安全服务。随后,前两者被整合为一个平台型产品(Hiddenlayer AISec Platform),主要采用本地化部署的形式进行售卖。

MLDR产品的部署模式类似SaaS化的EDR产品,包含:1)模型端部署的本地化探针-下图右上绿色部分,2)云端的检测能力API-下图右下蓝色部分。

探针从AI应用本地获取用户的Query和Response,上传到云端API进行研判,生成告警并回吐到产品运营平台或第三方运营工具。由于本地Agent存在部署问题,Hiddenlayer也和主流的MLOps平台进行适配合作,以简化用户的部署成本。

04 AI可信(合规)问题

AI的可信问题(AI Trust, AI Governance),即关注AI本身是否对人类和社会而言是安全、可靠、积极的。

这一话题往大了说关于自主意识、超级对齐 vs e-acc的讨论,离商业化太远;往小了说就是当前各个国家、组织对AI应用的合规需求。

合规需求包括欧盟人工智能法案(the EU AI Act)、地方性针对AI应用的限制法案如NYC 144、Colorado Law SB21-169,以及一些标准化组织发布的AI应用治理标准,如NIST AI RMF。

初创厂商清单

此类合规产品和安全行业已有的合规产品形态类似,包括简洁的部署方式(多为SaaS-云平台API直接对接)、详细的量化指标和图表、以及每条法规和现有资产的映射。

Credo的合规功能页面

Cranium的工作流程

05 AI滥用问题

技术是双刃剑,当黑灰产使用AI技术伪造不实信息获利时,需要有对应的技术手段来区分信息的真伪。

例如,攻击者可以使用AI生成的人物绕过金融支付的KYC环节,或者通过发布伪造知名人士的演讲视频操纵舆论,甚至在国家之间的信息战领域也看到了AI技术的发挥。

图片来源:"GenAI Against Humanity: Nefarious Applications of Generative Artificial Intelligence and Large Language Models"

「AI滥用」是一个AI、安全与各个行业广泛交叉的领域。

一方面,传统反欺诈、舆情分析、内容审查等赛道的供应商陆续发布了对AI生成内容的检测能力。另一方面,Reality defender此类专注于AIGC/DeepFake检测能力的初创厂商也登上RSAC创新沙盒的final list进入公众视野。

从技术角度而言,AIGC检测或DeepFake检测技术类似“AI时代的杀毒引擎”,通过信息的生成方式来判断一条信息的真实性,这一价值场景更大。此外,数字水印技术也被提出用于AI生成内容识别,如Google SynthID。

DeepFake / Image / Video 识别领域初创厂商

其他厂商推出的DeepFake识别能力

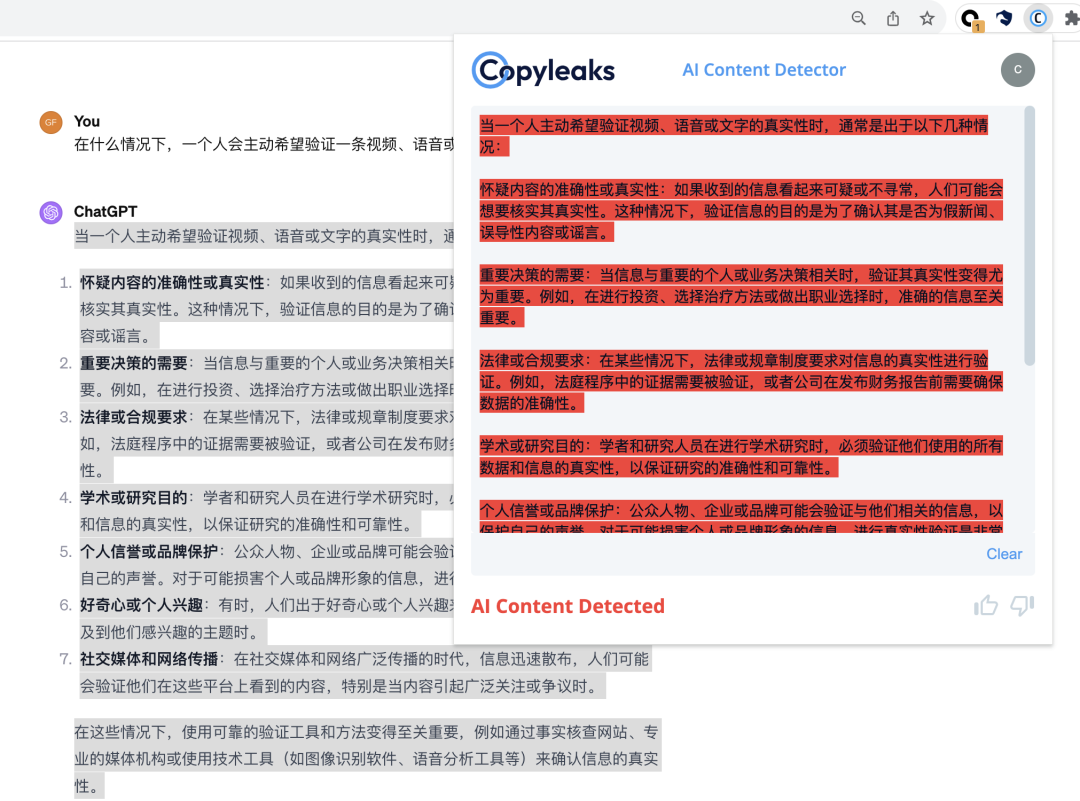

AI生成文本检测领域,典型的商业化场景是学术造假检测。

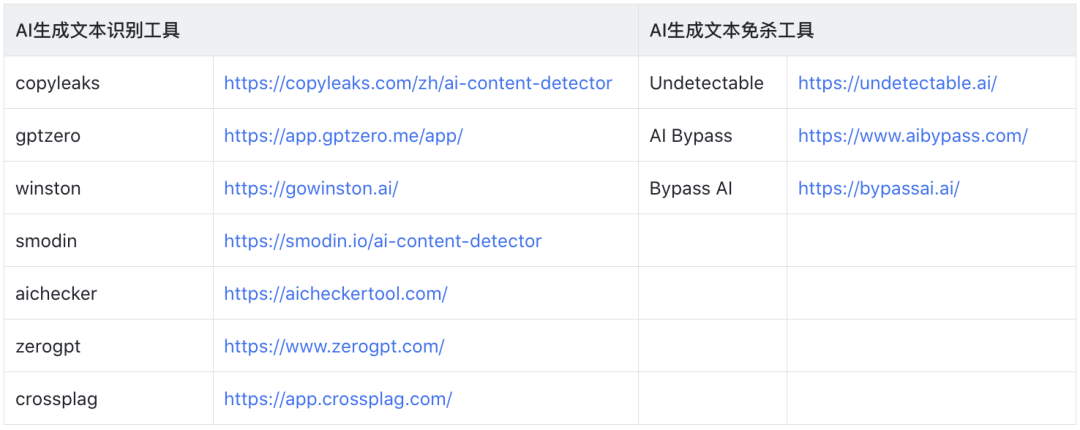

目前,国内用于毕业论文查重的「知网」也已经集成了AI文本检测能力。在攻击者视角,也有很多「AIGC免杀」工具(AI Humanizer),能够改写AI生成的文本,防止被识别为AI内容。

Copyleaks 用于检测AI生成文本的浏览器插件

AIGC免杀工具将AI生成文本进行拟人化

AI生成文本检测厂商及工具